Warum erklärbare KI?

Viele moderne KI-Systeme, insbesondere neuronale Netze, agieren als „Black Box“. Sie liefern zwar beeindruckende Ergebnisse, lassen aber kaum erkennen, wie oder warum eine Entscheidung zustande kam. Für gesellschaftlich relevante Anwendungen – etwa in Medizin, Bildung, Justiz oder Technik – ist diese Intransparenz problematisch.

Konzepte zur Erklärbarkeit von KI

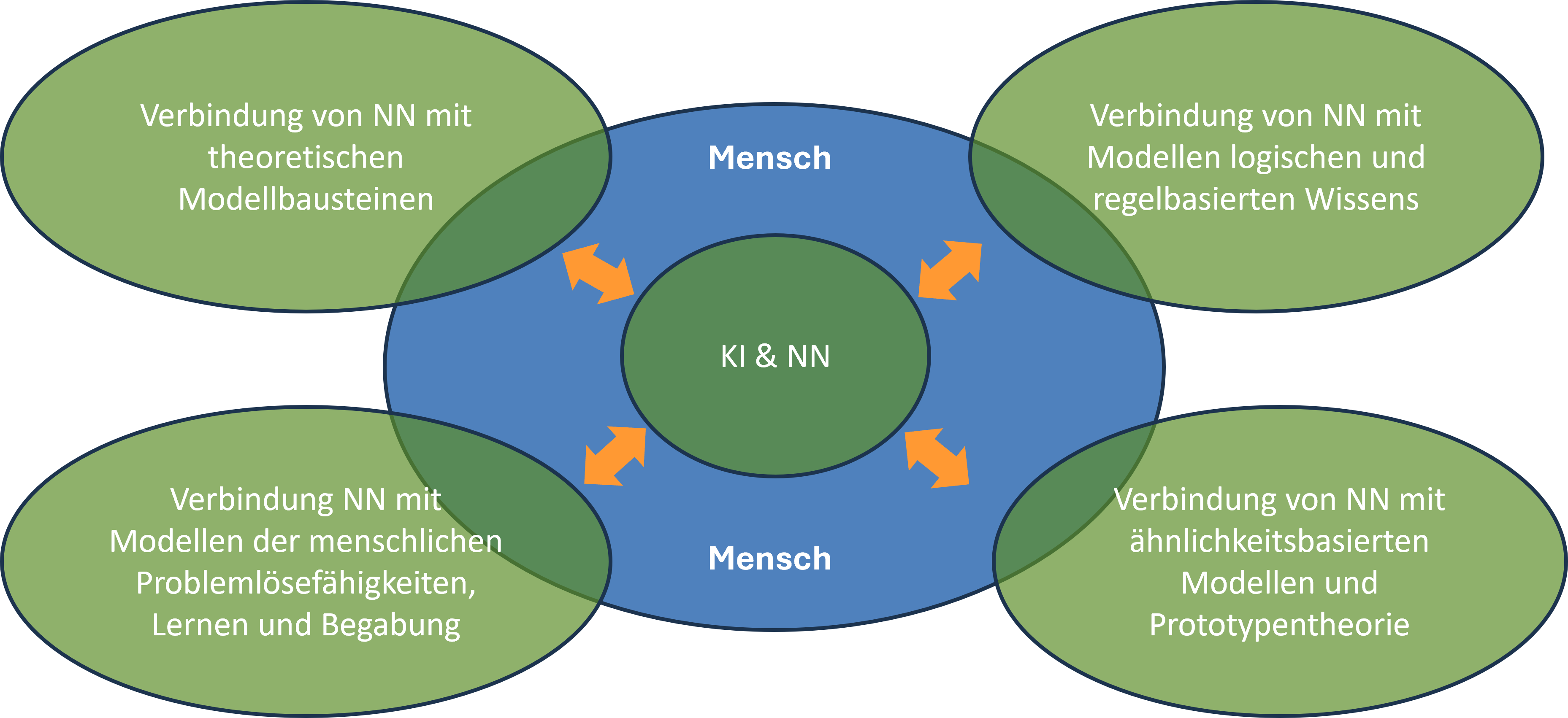

Wir verfolgen einen ganzheitlichen Ansatz, der sowohl technische als auch kognitionsbasierte Perspektiven einbezieht:

1. Logische und regelbasierte Modellierung

-

Feature-Analysen: Welche Eingabefaktoren haben zur Entscheidung beigetragen?

Visuelle Interpretierbarkeit: Welche Muster erkennt ein neuronales Netz?

Regelbasierte Darstellungen: Wie lassen sich komplexe Modelle durch verständliche Regeln annähern?

2. Physikalisch basierte Modellierung

Durch die Verknüpfung datenbasierter Modelle mit bekannten physikalischen oder theoretischen Strukturen lassen sich KI-Ergebnisse plausibel erklären. Dies schafft eine Brücke zwischen datengetriebener Intelligenz und dem klassischen wissenschaftlichen Weltverständnis.

3. Kognitive bzw. begabungstheoretische Modellierung

Die „kognitive bzw. begabungstheoretische Modellierung“ ist ein Ansatz zur Interpretation von Künstlicher Intelligenz (KI), bei dem die Funktionsweise und die Ergebnisse von KI-Systemen im Zusammenhang mit menschlichen Denkprozessen, Lernmechanismen und individuellen Begabungsstrukturen betrachtet werden.

4. Ähnlichkeitsbasierte Kognition des Menschen

Menschen lösen Probleme, indem sie neue Situationen mit prototypischen, bekannten Mustern vergleichen. Auch wenn KI in hochdimensionalen Merkmalsräumen arbeitet, kann durch geeignete Visualisierungen oder Reduktionen ein intuitives Verständnis ermöglicht werden.